а могло ли быть, что 1gb.ru тоже пользуется старым дата-центром ?

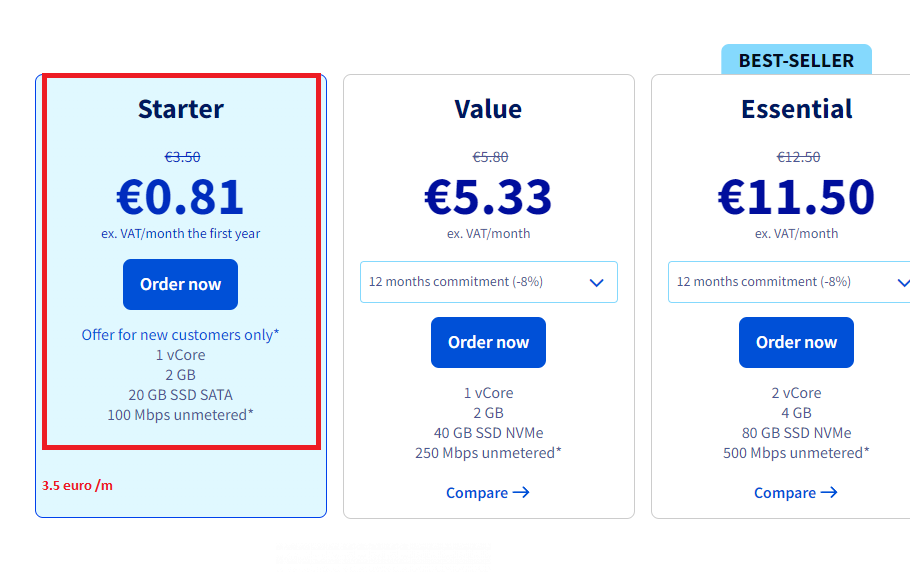

www.1gb.ru/l_rds1.php

года так 3-4 назад они выпускали современные процессоры

тогда в ходу были 9900k и подобное

и вот клиенты которые пришли ко мне покупать Hetzner, они говорили что их выселили из той компании — по причине того, что те грузили процессор на максимум. типо запрещено у них такое было. еще возмущались тогда что они продают, если товар который они купили нельзя использовать на полную.

я тогда подумал что это просто владельцы 1gb.ru тупо по своей прихоти решили избавиться от грузчика

но возможно там тоже были ВНЕШНИЕ факторы :) например 5 квт

черт!

я сейчас именно так и думаю.

года так 3-4 назад они выпускали современные процессоры

тогда в ходу были 9900k и подобное

и вот клиенты которые пришли ко мне покупать Hetzner, они говорили что их выселили из той компании — по причине того, что те грузили процессор на максимум. типо запрещено у них такое было. еще возмущались тогда что они продают, если товар который они купили нельзя использовать на полную.

я тогда подумал что это просто владельцы 1gb.ru тупо по своей прихоти решили избавиться от грузчика

но возможно там тоже были ВНЕШНИЕ факторы :) например 5 квт

черт!

я сейчас именно так и думаю.