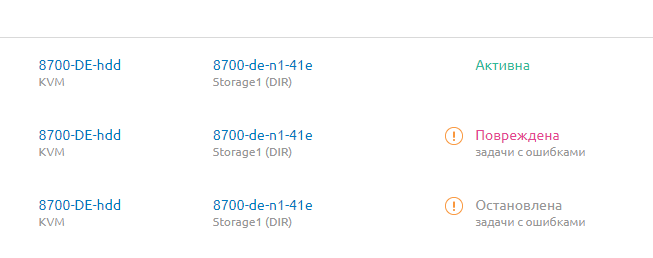

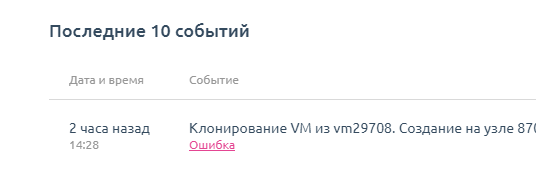

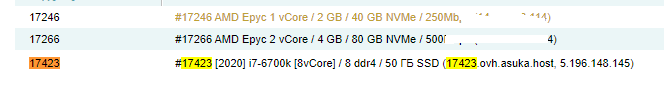

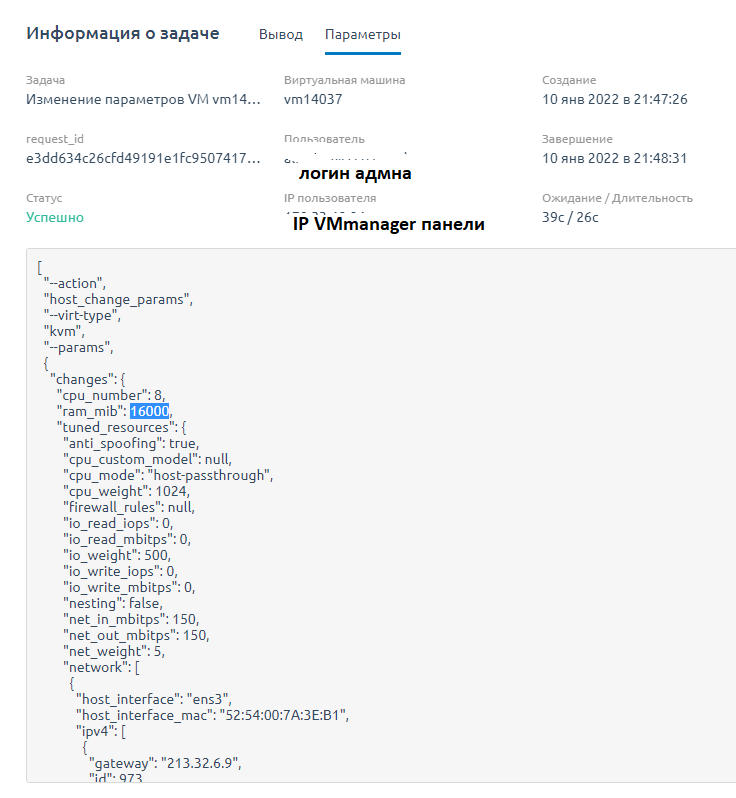

600 ТБ за 1 мес - проверили анализ, нашли "клонов" одного чела который потратил 100к уже чтобы убить пару дисков за 8000р

Percentage Used: 7%

Data Units Read: 15,873,385 [8.12 TB]

Data Units Written: 652,372,912 [334 TB]

Host Read Commands: 479,992,583

Host Write Commands: 21,656,590,620

Controller Busy Time: 11,252

Power Cycles: 10

Power On Hours: 356

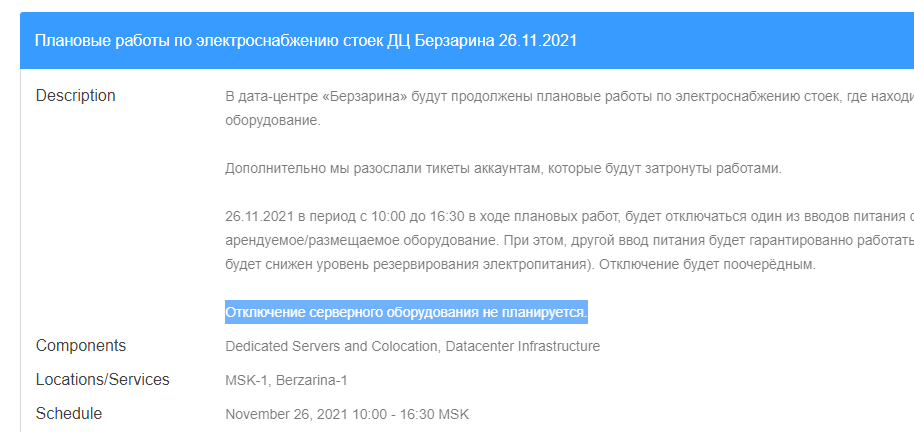

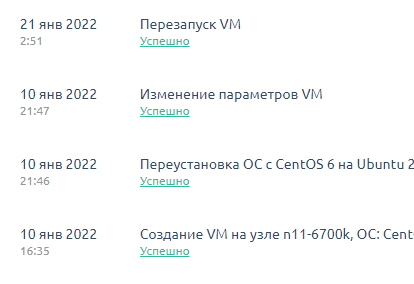

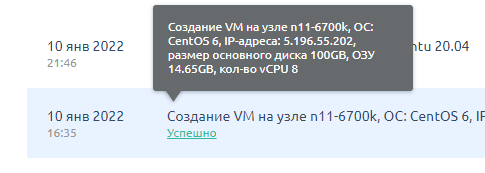

15 дней диску — 300 ТБ

месяц отработки — 600 ТБ

на 700 ТБ сдыхает диск? hosting.kitchen/yacolo-com/proshel-god-s-momenta-kak-my-dali-vtoroe-dyhanie-dc-cherez-7950x.html#comment3595

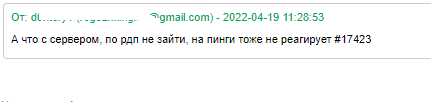

странное дело

он тратит суммарно 100к

чтобы убивать диски? которые стоят 8000р?

не верится мне

даже если ему чудом удастся закупиться виртуалками со всех узлов

то ему нада как минимум на 300000р накупить

и в итоге он убьет 20 узлов 20*8000 = 160000р

все равно в минусе будет

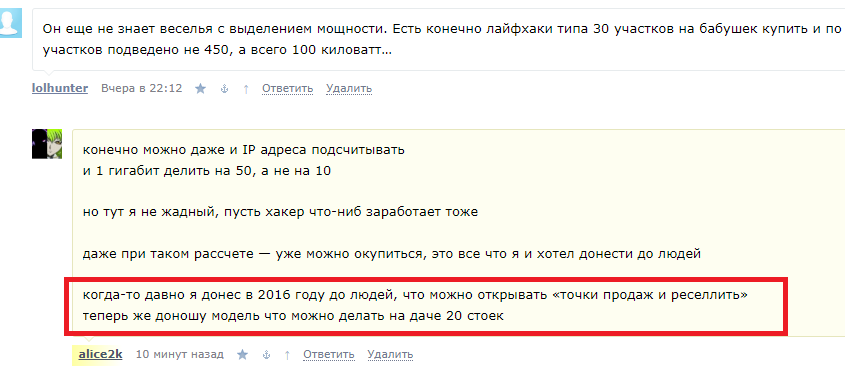

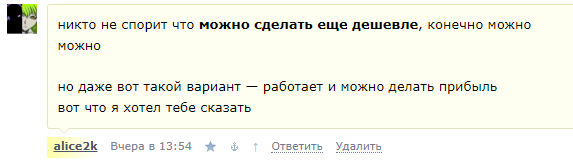

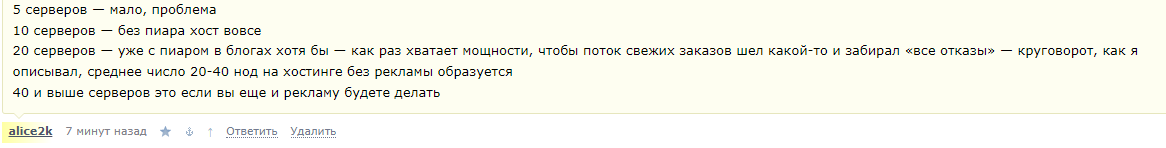

наверно тут дело в чем-то другом

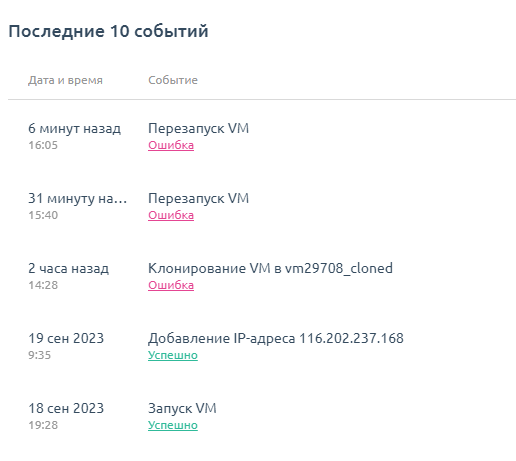

трудно сказать, т.к. за 10 лет не разу такие IOPSы не видели

а 500 ТБ записи обычно накапливается за 5 лет на ОВХ нодах

что-же за приложение такое может быть в 60000 IOPS?

или это создается для того чтобы проверить нас на слабо?

или это чтобы «соседи» страдали? так никто не страдает всем похуй